Les facteurs de classement de Google pour le référencement naturel et le fonctionnement de ses algorithmes

John Mueller l’évangéliste SEO de Google, a partagé plus de 50 conseils, vérités et contres vérités sur le fonctionnement de Google, ses algorithmes pour alimenter les Serps et ses facteurs de classement.

De nombreuses idées répandues sont ainsi balayées, le nombre de mots dans un texte n’est pas un facteur de classement, la quantité des backlinks n’a pas d’importance ou encore le nombre de visites sur un site ou des pages n’est pas un facteur de classement. À l’inverse respecter les Core web Vitals est un facteur de classement.

Ce résumé sur les bonnes pratiques pour un bon référencement naturel est classé en 3 catégories.

Les facteurs de classement de Google

1. Google n’a pas plus de 200 facteurs de classement

Dans le passé, Google a souvent affirmé qu’il y avait plus de 200 facteurs de classement que son algorithme prend en compte lors du classement du contenu.

Google s’éloigne officiellement de ce nombre, affirmant qu’il est trompeur et crée une fausse impression du fonctionnement de ses algorithmes.

2. La quantité de backlinks n’a pas d’importance

Le nombre total de liens pointant vers un site Web n’a pas d’importance pour Google.

Un bon lien d’un site Web pertinent aura plus d’impact que des millions de liens de mauvaise qualité.

« … vous pouvez créer des millions de liens sur des millions de sites Web si vous le souhaitez, et nous pourrions simplement les ignorer tous.

Ou il pourrait y avoir un très bon lien d’un site Web qui est, pour nous, un signe très important que nous devrions traiter ce site Web comme quelque chose de pertinent parce qu’il contient ce seul lien… Donc, le nombre total de liens est complètement hors de propos. «

3. Changer les dates d’un post n’améliorera pas le classement

Changer les dates de publication sur les pages Web, sans apporter de modifications significatives, n’aidera pas à améliorer le classement dans les résultats de recherche Google.

«Je ne pense pas que cela changerait quoi que ce soit en ce qui concerne la recherche, et nous ne classerions certainement pas ces pages différemment dans la recherche simplement parce que vous modifiez la date et l’heure sur une page.»

4. Le contenu en double n’est pas un facteur de classement négatif

Le contenu en double ne compte pas négativement pour un site en matière de classement de recherche. Google le gère en affichant une version du contenu et en ignorant les autres.

« Donc, si vous avez le même contenu sur plusieurs pages, nous n’afficherons pas toutes ces pages. Nous allons essayer d’en choisir un et de le montrer. Ce n’est donc pas un signal négatif associé à cela. Dans de nombreux cas, il est assez normal que vous ayez une certaine quantité de contenu partagé sur certaines pages.

5. La présentation peut avoir un impact sur les classements

La présentation visuelle d’un site web peut impacter sa visibilité dans les résultats de recherche.

« Parfois, ces petites différences jouent un rôle dans la façon dont les gens perçoivent votre site Web. Si, par exemple, vous avez quelque chose sur un sujet financier et que les gens viennent vous voir et disent « Eh bien, vos informations sont correctes, mais elles sont présentées d’une manière qui semble très amateur », alors cela pourrait refléter la façon dont votre site Web est perçu. Et à long terme, cela pourrait également refléter quelque chose qui est visible dans la recherche. »

6. Les avis des clients ne sont pas un facteur de classement

Les avis des clients comme trustpilot ne sont pas utilisés par les algorithmes de Google pour classer les résultats de recherche sur le Web.

Ils sont utilisés dans les classements de recherche locale, mais pas dans les classements de recherche Web organique. Ils ont toutefois une importance au yeux des usagers.

« Pour autant que je sache, nous n’utilisons pas le nombre de clients ou d’avis en matière de recherche sur le Web, en ce qui concerne le classement. Parfois, nous extrayons ces informations et nous pouvons les afficher comme une sorte de résultat riche dans les résultats de recherche.

7. Combien de temps pour voir une optimisation apparaître dans les Serps?

Après avoir résolu les problèmes de qualité sur un site, cela peut prendre jusqu’à un mois pour les voir dans les Serps, résultats de recherche de Google.

8. La suppression des commentaires de blogue peut avoir un impact sur les classements

Google indexe les commentaires de blogue comme les autres contenus, ce qui signifie qu’ils pourraient aider les pages Web à se classer dans les résultats de recherche.

Par conséquent, la suppression de tous les commentaires de blogue d’un site pourrait avoir un impact sur son classement.

« Je pense que c’est finalement à vous de décider. De notre point de vue, nous considérons les commentaires comme faisant partie du contenu. Nous reconnaissons également, dans de nombreux cas, qu’il s’agit en fait de la section des commentaires. Nous devons donc la traiter légèrement différemment. Mais en fin de compte, si les gens trouvent vos pages sur la base des commentaires, alors, si vous supprimez ces commentaires, nous ne serions évidemment pas en mesure de trouver vos pages sur cette base.

9. Core Web Vitals est un facteur de classement

Contrairement à ce que l’on croyait auparavant, John Mueller confirme que le facteur de classement Core Web Vitals est plus qu’un simple facteur de classement aléatoire.

« C’est un facteur de classement, et c’est plus qu’un départage, mais cela ne remplace pas non plus la pertinence. Selon les sites sur lesquels vous travaillez, vous le remarquerez peut-être plus, ou vous le remarquerez peut-être moins…

L’autre chose à garder à l’esprit avec les éléments essentiels du Web est que c’est plus qu’un facteur de classement aléatoire, c’est aussi quelque chose qui affecte la convivialité de votre site après son classement (lorsque les gens visitent réellement).

10. Le facteur de classement Core Web Vitals est calculé lentement

Les données Core Web Vitals sont collectées et mises à jour tous les 28 jours. Cela signifie que les scores rapportés dans Google Search Console, ou dans des outils tels que PageSpeed ??Insights, sont des rapports de ce que Google a mesuré au cours (environ) des 28 jours précédents.

Par conséquent, si les scores de base du Web Vitals sont améliorés, il faudra du temps pour voir un impact notable des signaux de classement.

« Je ne sais pas si c’est complètement décidé pour le moment. Je veux dire… une partie de cela est aussi qu’il y a juste un décalage général pour les données de toute façon… Nous devons en quelque sorte attendre cette période de temps jusqu’à ce que nous ayons collecté suffisamment de données…

Je soupçonne donc que ce n’est pas quelque chose qui sera optimisé pour… des mises à jour rapides, mais plutôt pour avoir une compréhension claire de l’image globale… je suppose que ce sera plus une chose lente qu’un changement en temps réel.

11. Le trafic n’a pas d’impact sur les éléments essentiels du Web

Les scores Core Web Vitals sont calculés à partir du trafic réel, mais le trafic lui-même n’influence pas le score.

« Peu importe si des millions d’utilisateurs voient cela ou tout simplement… je ne sais pas… des milliers d’utilisateurs le voient… le nombre pur de visiteurs de votre site n’est pas un facteur lorsqu’il s’agit de l’essentiel du Web et en général pas non plus un facteur de classement.

12. Google My Business est essentiel pour les classements de recherche locale

Pour bien figurer dans les résultats de recherche locaux, l’optimisation de votre fiche Google My Business est tout aussi importante que l’optimisation de votre site Web.

« … on dirait que ce que vous cherchez est un service local ou une entreprise locale, essentiellement. Et pour cela, je m’assurerais que vous disposez vraiment d’une fiche Google My Business vraiment solide. Parce que c’est quelque chose qui peut être montré un peu plus facilement dans les résultats de recherche pour des requêtes comme celle-ci.

Et en particulier, les requêtes qui incluent quelque chose comme « près de moi ». Ce n’est pas quelque chose de spécifique sur votre site Web. Mais ce que vous devez faire ici, c’est simplement vous assurer que votre emplacement est très clairement défini sur vos pages, afin que nous puissions reconnaître que cet emplacement est associé à votre site Web ou à cette page et que l’utilisateur se trouve à cet endroit.

13. Le prix du produit n’est pas un facteur de classement

Offrir des prix compétitifs peut aider à attirer plus de clients, mais cela n’aura aucun impact sur les classements de recherche des magasins de commerce électronique.

« Du point de vue de la recherche uniquement sur le Web, non, nous n’essaierions pas de reconnaître le prix sur une page et de l’utiliser comme facteur de classement.

Nous ne dirions donc pas que nous prendrons le moins cher et le classerons plus haut. Je ne pense pas que cela aurait vraiment du sens.

14. Le nombre de mots n’est pas un facteur de classement

Il n’y a pas de vérité dans la théorie selon laquelle le nombre de mots dans un texte est important pour les classements de recherche.

Si un article plus court communique les mêmes informations qu’un article plus long, Google reconnaîtra qu’il offre la même valeur aux chercheurs.

Comme le dit John Mueller, cela n’a pas de sens de classer le contenu en fonction de la page qui contient plus de mots que l’autre.

« Nous n’utilisons pas le nombre de mots pour le classement. C’est bien d’utiliser le nombre de mots pour *vous-même* comme ligne directrice pour votre contenu, si cela encourage un meilleur contenu de la part de vos rédacteurs. »

15. Les titres de page originaux sont toujours utilisés pour les classements

Suite à une mise à jour de la façon dont Google génère les titres de page dans les résultats de recherche, John Mueller confirme que les titres originaux ne sont pas moins importants qu’auparavant.

Le titre de page soigneusement conçu que vous avez écrit sera toujours utilisé pour les classements de recherche même si Google le remplace dans les Serps.

« Vous ne savez jamais comment ces choses évoluent au fil du temps, mais au moins pour le moment, nous continuons à utiliser ce que vous avez dans votre balise de titre, dans votre élément de titre, comme quelque chose que nous pouvons utiliser pour le classement.

Même si lorsque nous affichons le titre de votre page, nous changeons peut-être ce mot-clé qui vous intéresse, nous l’utiliserons toujours pour le classement.

16. EAT n’est pas un facteur de classement

Après que Google eut écrit sur EAT (expertise, autorité et fiabilité) dans ses directives pour l’évaluateur de qualité, une croyance a commencé à émerger qu’il s’agit d’un facteur de classement direct.

Ce n’est pas le cas, confirme John Mueller. Et il n’y a pas non plus de « score EAT ».

« … ce n’est pas quelque chose où je dirais que Google a un score EAT. C’est plus quelque chose qui évolue dans nos algorithmes au fil du temps… nous essayons de les améliorer, nos évaluateurs de qualité essaient de revoir nos algorithmes et ils examinent ces choses.

Il peut donc y avoir un certain chevauchement ici, mais ce n’est pas qu’il y ait un facteur technique qui est impliqué qui prendrait en quelque sorte des éléments spécifiques et les utiliserait comme facteur de référencement.

17. Il n’y a pas de facteur décisif dans la recherche

Il n’y a pas de facteur de classement unique sur lequel vous pouvez pointer et dire que c’est le facteur décisif avant les autres.

Un facteur de classement peut avoir un poids considérable pour une requête et n’avoir aucune importance pour une autre.

«Et ce n’est pas non plus le cas qu’un type particulier de facteur au sein de ce grand réseau soit le seul facteur décisif ou que vous puissiez dire que ce facteur joue un rôle de 10 % parce que peut-être pour certains sites, pour certaines requêtes, il ne joue pas un rôle du tout.

Et peut-être pour d’autres sites, pour d’autres requêtes, c’est le facteur décisif. C’est vraiment difficile de dire comment les garder ensemble.

18. Les balises de titre sont un signal fort

Le texte dans une balise titre est un signal fort envoyé à Google, lui indiquant de quoi parle une page et ce pour quoi vous voulez qu’elle se classe.

« Et lorsqu’il s’agit de texte sur une page, un titre est un signal très fort nous indiquant que cette partie de la page concerne ce sujet.

… que vous mettiez cela dans une étiquette H1 ou H2 ou H5 ou autre, cela n’a pas tellement d’importance.

Mais plutôt une sorte de signal général que vous nous donnez qui dit… cette partie de la page traite de ce sujet. Et cette autre partie de la page traite peut-être d’un sujet différent.

19. Les mots-clés dans le nom de domaine n’ont pas d’impact sur les classements

Un site Web n’est plus susceptible d’être classé pour un mot-clé particulier si ce mot-clé se trouve dans le nom de domaine.

Les mots-clés du nom de domaine ne sont pas un signal de classement.

Vous êtes bien mieux avec un domaine qui reflète le nom de votre entreprise ou qui a quelque chose à voir avec votre marque.

« Ce n’est pas parce qu’un site Web a un mot-clé dans son nom de domaine qu’il est plus pertinent que d’autres pour ce mot-clé.

Bref, vous n’avez pas besoin de mettre des mots-clés dans le nom de domaine.

Le contenu principal

20. Rendez la requête principale mise en avant aussi visible que possible

John Mueller conseille fortement de placer la requête principale d’une page là où elle est le plus visible, y compris les titres, les en-têtes, les sous-titres, etc.

« Je recommanderais que si vous souhaitez nous dire quelque chose à propos de votre page, de le rendre aussi visible que possible.

Alors, ne vous contentez pas de mentionner cela en un mot en bas de votre article. Mais plutôt, utilisez-le dans vos titres, utilisez-le dans vos rubriques, utilisez-le dans vos sous-titres, utilisez-le dans les légendes d’images…

Toutes ces choses, pour qu’il soit aussi clair que possible pour les utilisateurs et pour Google lorsqu’ils accèdent à votre page que cette page traite de ce sujet. »

21. Mauvais contenu améliorez-le ou supprimez-le

Lorsqu’on lui a demandé s’il était préférable d’améliorer le contenu de mauvaise qualité plutôt que de le supprimer, John Mueller a déclaré que l’améliorer était la meilleure voie à suivre.

Cependant, si vous n’avez pas l’intention d’améliorer le contenu, vous devez le supprimer.

« Je pense que si c’est quelque chose que vous pensez être un bon contenu que vous souhaitez publier avec votre site Web, avec votre nom, alors je le garderais. Ce n’est pas parce que c’est vieux que c’est mauvais.

Mais si vous le regardez et vous dites, oh, c’est embarrassant pour moi maintenant, je ne veux pas que ce soit en ligne, je dirais soit de l’améliorer, soit de le supprimer. »

22. Mettez un contenu unique au-dessus de la ligne de flottaison

Une page Web doit avoir au moins un contenu unique au-dessus de la ligne de flottaison

Il y aura toujours du contenu dupliqué sur différentes pages, mais visez au moins une quantité minimale de contenu unique en haut de la page.

« La partie importante pour nous est vraiment qu’il y a une certaine quantité de contenu unique dans la zone au-dessus de la ligne de flottaison. Donc, si vous avez une bannière sur le dessus, et que vous avez une image générique de héros encore au-dessus, c’est très bien. Mais les contenus au-dessus de la ligne de flottaison doivent être uniques pour cette page.

23. L’orthographe et la grammaire sont prioritaires

Une orthographe et une grammaire médiocres sont considérées par Google comme un problème de qualité, car elles peuvent avoir un impact direct sur l’expérience d’un utilisateur.

« En ce qui concerne les fautes d’orthographe, les fautes de grammaire, je pense que c’est quelque chose qui ressemble un peu plus à une zone grise dans la mesure où d’une part, nous devons être capables de reconnaître de quoi parle une page.

Et si nous ne pouvons pas reconnaître cela parce qu’il y a tellement d’erreurs sur la page dans le texte, alors cela rend les choses plus difficiles.

L’autre aspect est également que nous essayons de trouver un contenu de très haute qualité sur le Web et parfois il peut sembler qu’une page ait un contenu de qualité inférieur, car elle contient beaucoup d’erreurs grammaticales et techniques dans le texte.

Je dirais presque que l’orthographe et la grammaire sont probablement pour la plupart des sites Web une priorité plus élevée que le code HTML défectueux. »

24. La plupart des contenus sont indexés en une semaine

Lorsqu’une nouvelle page est publiée, son indexation peut prendre de plusieurs heures à plusieurs semaines.

John Mueller soupçonne que la plupart des bons contenus sont récupérés et indexés en une semaine environ.

25. Le même contenu dans différents formats n’est pas en double

Un contenu identique publié dans différents formats, comme une vidéo et un article de blogue, n’est pas considéré comme du contenu en double.

Google n’est pas capable de transcrire le dialogue d’une vidéo pour le comparer au contenu écrit d’un article de blogue.

« Tout d’abord, nous ne faisons pas d’analyse de texte des vidéos pour ensuite les mapper sur des pages Web. Si votre vidéo a le même contenu que votre article de blogue, c’est quand même quelque chose de différent. Les gens vont parfois sur Google avec l’intention de lire quelque chose, et parfois ils vont sur Google avec l’intention de regarder ou d’écouter quelque chose, et ce sont des choses très différentes.

Nous ne dirions pas que le texte de cette vidéo est exactement le même qu’un article de blogue, donc nous n’en montrons aucun ou nous n’en montrons qu’un. Donc, si vous avez une vidéo qui correspond à votre article de blogue, je pense que c’est parfaitement bien.

26. Beaucoup de liens d’affiliation, oui si le contenu est précieux

Il n’y a aucun mal à avoir beaucoup de liens d’affiliation sur une page si le contenu principal ajoute de la valeur au Web.

Les sites Web sont libres d’utiliser autant de liens d’affiliation qu’ils le souhaitent sur une seule page, à condition qu’il y ait également un contenu utile.

«Il n’y a pas de limites. De notre côté, ce n’est pas que nous disons que les liens d’affiliation sont mauvais ou problématiques. C’est plus une question de, eh bien, vous devez également avoir du contenu utile sur votre page. C’est donc un peu l’angle que nous prenons là.

Le nombre de liens d’affiliation que vous avez sur un site n’a aucune importance. Le rapport entre les liens et la longueur de l’article est également totalement hors de propos.

27. Les vidéos intégrées ont la même valeur que les vidéos téléchargées

Les vidéos intégrées à partir d’autres sources ont la même valeur SEO que les vidéos hébergées nativement sur un site Web.

« C’est essentiellement la même chose. Il est très courant que vous ayez un CDN (réseau de diffusion de contenu) distinct pour les vidéos, par exemple, et techniquement, il s’agit d’un site Web distinct. De notre point de vue, si cela fonctionne pour vos utilisateurs, si votre contenu est correctement accessible pour l’indexation, alors c’est parfaitement bien.

28. Trop de liens internes peuvent réduire leur valeur

L’utilisation d’un nombre important de liens internes sur la même page peut diluer leur valeur.

Lorsqu’on lui a demandé si trop de liens internes sur une page faisaient plus de mal que de bien, John Mueller a répondu :

«Oui et non. Je pense que, dans le sens où nous utilisons les liens internes pour mieux comprendre la structure d’une page, et vous pouvez imaginer la situation où si nous essayons de comprendre la structure d’un site Web, avec les différentes pages qui existent, si toutes les pages sont liées à toutes les autres pages du site Web, où vous avez essentiellement un lien interne complet sur chaque page, alors il n’y a pas de véritable structure là-bas.

Donc, quel que soit le PageRank, l’autorité et les choses comme ça, vous ne fournissez essentiellement pas une structure claire du site Web. Et cela rend plus difficile pour les moteurs de recherche de comprendre le contexte des pages individuelles de votre site Web.

29. Images au lieu de HTML pour les graphiques

Un cas rare où John Mueller recommande d’utiliser des images au lieu de texte brut est lorsque vous affichez un graphique dans le contenu principal.

Il n’y a aucun avantage à coder un graphique avec HTML. Une image avec un attribut alt compréhensible est parfaitement acceptable.

« Je pense que cela dépend un peu de ce que vous voulez atteindre avec le graphique. Habituellement, ce genre de choses, je les ajouterais simplement en tant qu’image et je m’assurerais que vous avez également un attribut alt compréhensible pour l’image.

Donc, s’il y a des informations critiques dans ce graphique que vous devez faire passer, placez-les dans les attributs alt. Pour que nous puissions le récupérer sous forme de texte, afin que les personnes qui ne peuvent pas voir l’image puissent également obtenir cette information. Mais en général, je n’utiliserai que des images.

30. Le texte d’ancrage doit fournir un contexte

Les liens internes peuvent aider Google à découvrir plus d’articles sur un site, de sorte que le texte d’ancrage doit fournir un contexte sur le sujet de la page liée.

« En ce qui concerne les liens internes, vous nous donnez un signal de contexte. Donc, en gros, vous dites, dans cette partie de mon site Web, vous trouverez des informations sur ce sujet. Et c’est ce que vous utiliseriez comme texte d’ancrage pour ces liens internes…

En ce qui concerne les liens externes, si vous créez un lien vers les sites Web d’autres personnes, ce sera la même chose. Par exemple, fournissez un contexte pour lequel les gens devraient cliquer sur ce lien, quel type d’informations supplémentaires il donne. »

31. Un texte d’ancrage long donne à Google plus de contexte

Il n’y a rien de mal à utiliser un long texte d’ancrage sur une page. En fait, cela peut aider. Google utilise un texte d’ancrage pour en savoir plus sur la page à laquelle le lien est lié.

Plus le texte d’ancrage est long, plus vous donnez de contexte à Google. Cette information sera prise en compte lors du classement de la page.

« Je ne pense pas que nous fassions quoi que ce soit de spécial avec la longueur des mots dans le texte d’ancrage. Mais plutôt, nous utilisons ce texte d’ancrage comme un moyen de fournir un contexte supplémentaire pour les pages individuelles.

Parfois, si vous avez un texte d’ancrage plus long, cela nous donne un peu plus d’informations. Parfois, c’est un peu comme une simple collection de mots-clés différents.

32. Google ne comprend pas le sarcasme

Écrire du contenu avec un ton sarcastique peut attirer les lecteurs, mais cela ne rapportera aucun point à Google.

L’algorithme de Google est susceptible de mal comprendre le sarcasme, évitez donc de l’utiliser lorsque vous écrivez du contenu qui communique des informations critiques.

«Je dirais qu’il y a certainement un risque que l’on comprenne mal des choses comme ça ou qu’on ne comprenne pas quand il y a du sarcasme sur une page.

Et surtout s’il s’agit de quelque chose où il est vraiment essentiel pour vous de faire passer le bon message à Google et à tous les utilisateurs, alors je ferais en sorte qu’il soit aussi clair que possible.

Peut-être que dans les cas où vous parlez d’informations médicales ou sensibles, essayez d’éviter les sarcasmes.

Si vous écrivez sur… un sujet de divertissement ou quelque chose comme ça, alors c’est probablement moins un problème.

Référencement technique

33. Certains types de balisage de schéma ne peuvent pas être combinés

Les résultats enrichis de Google peuvent combiner certains types de balisage de données structurées, mais pas d’autres.

« … dans les résultats de la recherche, certains des types de résultats enrichis que nous pouvons combiner et d’autres que nous ne pouvons pas combiner. Par exemple, si vous avez une recette et que vous avez des notes, nous pouvons souvent les combiner dans les résultats de recherche, dans un type de résultats enrichis.

Cependant, si vous avez une FAQ et un mode d’emploi, alors d’après ce que je me souviens à quoi elles ressemblent, ce sont des choses qui ne seraient pas combinées dans un seul type de résultat enrichi, ce qui signifie que nos systèmes devraient choisir d’en montrer un.

34. Aucun avantage pour une structure d’URL plate

Une structure d’URL artificiellement plate, où chaque page semble se trouver à un clic de la page d’accueil, n’est pas nécessaire.

Google ne se soucie pas du nombre de barres obliques qu’il y a dans une URL. Il traite les URL comme des identifiants de contenu, et non comme un moyen de comprendre la structure du site

« Vous ne devez pas avoir une structure de répertoire artificiellement plat. De ce point de vue, si vous avez une structure de répertoire que les utilisateurs peuvent reconnaître, je pense que c’est tout à fait bien. Il n’y a pas besoin de cacher ce genre de structure d’URL des utilisateurs en faisant la réécriture d’URL ou quelque chose comme ça«.

35. Les erreurs 404 sont normales

Il est normal qu’un site contienne des erreurs 404, donc Google ne les considère pas comme un facteur de classement négatif.

Il n’y a aucune raison de s’inquiéter même si la Search Console montre que jusqu’à 40% des pages d’un site sont des 404.

« Je ne pense pas que cela nous semblerait inhabituel. Ce n’est pas comme si nous voyions cela comme un signal de qualité ou quoi que ce soit. La seule fois où je pense que les 404 commenceraient à ressembler à quelque chose de problématique pour nous, c’est lorsque la page d’accueil commence à renvoyer des 404. Ensuite, cela pourrait être une situation dans laquelle nous pourrions penser que le site n’est plus en ligne »

Mais si certaines parties du site sont 404, c’est quelque chose de technique, comme, ça n’a pas d’importance.

36. CCTLD non requis pour le ciblage géographique

Un domaine de premier niveau de code de pays (CCTLD), comme pour l’Allemagne un .de, n’est pas nécessaire pour cibler géographiquement les usagers dans ce pays.

« Non, ce n’est pas obligatoire.

En général, si vous souhaitez utiliser le ciblage géographique, il existe deux façons de le faire.

La première consiste à utiliser le domaine de premier niveau au niveau du pays, ce qui correspondrait au .de pour l’Allemagne dans ce cas.

L’autre consiste à utiliser un domaine de premier niveau générique et à utiliser un paramètre de ciblage géographique dans la search console.

Cela pourrait être, par exemple, un site Web .com ou .net ou encore .info etc. N’importe lequel d’entre eux fonctionnerait également, puis vous définissez simplement le ciblage géographique pour l’Allemagne. »

37. Aucune solution technique pour les problèmes de qualité

Pour qu’un site Web soit pris au sérieux par Google, il doit répondre à un certain niveau de qualité, qui ne peut être atteint avec des correctifs techniques uniquement.

« La qualité du site Web n’est pas quelque chose que vous pouvez corriger avec des changements techniques. Si vous voulez que les moteurs de recherche prennent votre site plus au sérieux, vous devez vraiment, vraiment améliorer le contenu.

38. La longueur de l’URL est un signal important pour la rendre canonique

La longueur d’une URL est un signal que Google utilise pour déterminer quelle version d’une URL est canonique.

Google est susceptible de choisir la version plus courte d’une URL à afficher dans les résultats de recherche, à condition que tout le reste soit égal.

« Nous utilisons très peu la longueur de l’URL pour la canonisation, donc si nous repérons url.htm?utm=greencheeseandham et url.htm, nous pourrions choisir url.htm comme canonique en supposant que tout le reste est identique. Cela peut donner l’impression que des URL plus courtes sont meilleures pour le référencement, mais ce n’est vraiment qu’un effet secondaire.

39. Conservez les mêmes URL lors de la refonte d’un site

Une refonte du site pourrait faire plus de mal que de bien si vous allez jusqu’à modifier les URL.

Lorsque vous apportez des modifications et/ou des améliorations à un site, assurez-vous que les URL restent les mêmes.

Si les URL sont modifiées, Google peut les explorer en tant que nouvelles pages, ce qui signifie repartir de zéro en termes de classement de recherche.

« Pour les refontes, il y a parfois quelques éléments qui s’assemblent et il est parfois difficile de comprendre exactement ce qui se passe.

Mais la principale chose à laquelle je ferais attention lorsque vous effectuez une refonte est de m’assurer :

Que les URL restent les mêmes autant que possible afin que vous ne changiez pas la structure de l’URL.

Que le maillage interne reste le plus possible le même. Que le contenu et la mise en page des pages restent les mêmes autant que possible.

40. Les données structurées sont un signal « extrêmement léger »

Les données structurées aident à communiquer à Google de quoi parle une page, mais les référenceurs ne devraient pas en dépendre pour avoir un impact sur les classements de recherche.

Pourquoi? Parce que ce n’est qu’un signal important et non un signal important. Si vous voulez vraiment indiquer clairement à Google ce pour quoi vous voulez qu’une page soit classée, communiquez-le via le contenu principal.

41. Plusieurs balises H1 sur la même page, c’est bien

Google recommande-t-il d’utiliser qu’une balise H1 ? Non. Les éditeurs sont libres d’utiliser autant de rubriques H1 qu’ils le souhaitent.

« Vous pouvez utiliser les balises H1 aussi souvent que vous le souhaitez sur une page. Il n’y a pas de limite ni limite supérieure ni limite inférieure.

Votre site se classera parfaitement bien sans balises H1 ou avec cinq balises H1.

42. Liens Nofollow dans les messages d’invités

Si vous soumettez une publication d’invité sur un autre site avec un lien vers votre site, ce lien doit comporter une balise nofollow.

Il en va de même pour les articles invités publiés sur votre site avec un lien renvoyant vers le site de l’auteur.

Google considère les publications d’invités comme une promotion du site de l’auteur, de sorte que tout lien dans le contenu n’est pas considéré comme un lien naturel.

Par conséquent, une balise nofollow doit être présente pour empêcher Google de penser que vous êtes impliqué dans une sorte de schéma de liens.

« La partie qui pose problème, ce sont les liens – si vous fournissez le contenu/les liens, alors ces liens ne devraient pas transmettre de signaux et devraient avoir le rel-sponsored / rel-nofollow attaché. C’est bien de le voir comme un moyen d’atteindre un public plus large.

Essentiellement, si le lien se trouve dans le message d’invité, il ne devrait pas être suivi, même s’il s’agit d’un lien « naturel » que vous ajoutez là.

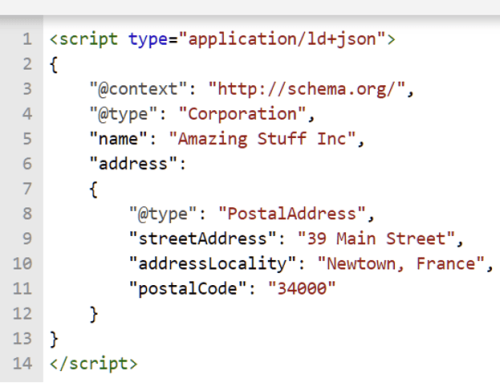

43. Google préfère les données structurées JSON-LD

Il existe deux principaux types de données structurées avec lesquelles vous pouvez baliser votre site.

L’un est JSON-LD, l’autre est microdonnées.

Google prend en charge les deux types, mais préfère JSON-LD.

« Nous préférons actuellement le balisage JSON-LD. Je pense que la plupart des nouvelles données structurées qui sortent en premier lieu sont en JSON-LD.

44. Les méta-titres riches en mots-clés ne sont pas contraires aux directives de Google

Bien que Google ne le recommande pas, remplir le méta-titre d’une page avec des mots-clés n’est pas contraire aux directives du moteur de recherche.

Auparavant, on croyait que cela serait considéré comme du bourrage de mots clés et entraînerait une rétrogradation.

Selon John Mueller, ce n’est pas le cas.

« Ce n’est pas contre nos directives adressées aux webmasters. Ce n’est pas quelque chose que nous considérons comme problématique. Je pense que, tout au plus, c’est quelque chose que vous pourriez améliorer si vous aviez un titre mieux adapté parce que nous comprenons un peu mieux la pertinence.

Et je soupçonne que la plus grande amélioration avec un titre à cet égard est que si vous pouvez créer un titre qui correspond à ce que l’utilisateur recherche réellement, il est alors un peu plus facile pour lui de cliquer sur un résultat de recherche parce qu’il pense « oh ça correspond vraiment à ce que je cherchais.

Référencement général

45. Le référencement ne deviendra pas obsolète

John Mueller dit qu’il ne pense pas que les moteurs de recherche progresseront un jour au point ou le référencement deviendra obsolète.

Cela dissipe les inquiétudes selon lesquelles l’apprentissage automatique de Google progressera à un point où un bon contenu pourra être classé sans référencement.

«Je pense que l’une des choses qui préoccupent toujours les gens est tout ce qui concerne l’apprentissage automatique et que les algorithmes de Google iront jusqu’à comprendre automatiquement chaque site Web et que le référencement sera obsolète, personne n’aura besoin de le faire. Je ne pense pas que cela se produira.

46. Moment parfait pour les spécialistes en SEO

Avec le lancement de la mise à jour Page Experience, John Mueller dit que le moment est venu de se lancer dans l’optimisation des sites Web.

« Un bon consultant SEO qui aide un site à entrer dans le vert peut valoir beaucoup d’argent. Si vous aimez ce genre de travail, si vous aimez travailler en profondeur sur des sites Web et avez de la pratique avec diverses configurations/CDN/plugins/frameworks, c’est le moment idéal pour passer au niveau supérieur et être bien payé pour cela.

47. Parfois, il n’y a pas de solution pour un bon référencement

Parfois, le référencement naturel SEO n’est pas la solution pour améliorer le classement d’un site, déclare John Mueller :

« L’une des choses à garder à l’esprit est qu’il est possible qu’il n’y ait tout simplement pas de solution de référencement. Parfois, ce n’est pas un problème technique, parfois ce n’est pas quelque chose que vous pouvez résoudre simplement en « achetant un tas de liens », parfois c’est simplement que la stratégie du site est désormais obsolète. »

48. Google indexe les versions mobiles des pages par défaut

Le passage à l’indexation mobile-first signifie que Google indexe les versions mobiles d’une page par défaut, plutôt que le bureau.

Dans le cas de sites avec des URL mobiles distinctes, cela signifie que la version m-dot est utilisée pour l’indexation.

« Le changement avec l’indexation mobile first est que nous utiliserons la version mobile (m-dot) comme version pour l’indexation, au lieu de la version www (desktop). Pour la plupart des sites, ce changement s’est déjà produit. Si votre site est déjà indexé avec mobile, rien ne changera.

49. Ne comptez pas sur Google Discover Traffic

Le trafic de référence de Google Discover est susceptible de fluctuer, il est donc important de ne pas en dépendre en tant que source cohérente.

« … avec Discover, c’est quelque chose qui n’est pas lié à une requête spécifique. Il est donc très difficile de dire à quoi vous devez vous attendre, car vous ne savez pas combien de personnes sont intéressées par ce sujet ou où nous serions potentiellement en mesure de le montrer.

C’est donc quelque chose où, si vous voyez beaucoup de visibilité dans Google Discover, je pense que c’est fantastique. Je serais juste prudent et je me rendrais compte que c’est quelque chose qui peut changer assez rapidement.

50. Établissez des liens avec les « RP numériques »

John Mueller parle positivement de la création de liens grâce aux relations publiques numériques (relations publiques). Il précise que ce n’est pas du spam. En fait, cela peut être aussi critique que le référencement technique.

« J’aime certaines des choses que je vois dans les relations publiques numériques, c’est dommage qu’elles soient souvent associées au type de création de liens spammé. C’est tout aussi essentiel que le référencement technologique, probablement plus dans de nombreux cas. »

51. Les classements mobiles et de bureau sont contextuellement personnalisés

Pour certaines recherches, les besoins des utilisateurs individuels sont différents selon qu’ils effectuent une recherche à partir d’un mobile ou d’un ordinateur, et cela peut influencer les classements.

« … Il est normal que les classements sur ordinateur et mobile soient différents.

Parfois, c’est en rapport avec des choses comme la vitesse. Parfois, cela concerne des choses comme la convivialité mobile.

Parfois, cela concerne également les différents éléments affichés dans la page de résultats de recherche.

Par exemple, si vous effectuez une recherche sur votre téléphone, vous souhaitez peut-être plus d’informations locales parce que vous êtes en déplacement.

Alors que si vous effectuez une recherche sur un ordinateur de bureau, vous souhaitez peut-être afficher plus d’images ou de vidéos dans les résultats de la recherche. Nous avons donc tendance à montrer un mélange de différents types de résultats de recherche.

Et à cause de cela, il peut arriver que le classement ou la visibilité des pages individuelles diffère entre le mobile et le bureau.

Et c’est essentiellement normal. Cela fait partie de la façon dont nous procédons au classement. Ce n’est pas quelque chose qui serait lié à l’aspect technique de l’indexation du contenu.

52. La syndication peut avoir un impact sur les classements

La republication et/ou la syndication de contenu sur d’autres sites peut réduire les chances de classement de votre site Web pour les mots clés cibles.

John Mueller considère que la syndication/republier est une mauvaise idée:

« Si vous republiez, il s’agit alors d’un contenu en double. Si votre objectif est de toucher un public plus large, allez-y. Si votre objectif est que seul votre site soit classé pour ces requêtes, alors la syndication / la republication est une mauvaise idée. Choisissez vos objectifs et sélectionnez le travail qui vous aide à les atteindre.

53. La recherche n’est pas une science

La recherche n’est pas une science exacte dans le sens où tous les sites Web doivent suivre les mêmes étapes pour obtenir un classement favorable.

Il peut y avoir plusieurs façons d’obtenir des classements élevés dans Google. Chaque site n’a pas à suivre le même schéma directeur.

«Je pense que c’est vraiment important de garder à l’esprit dans le sens où il n’y a pas de vérité absolue concernant quelle page doit être classée pour quelle requête…

Ce n’est donc pas que chaque site doit faire la même chose, mais il existe plusieurs façons d’y arriver et vous n’avez pas à suivre aveuglément un seul facteur de classement pour arriver au résultat final.

54. Les principales mises à jour ont un impact sur Google Discover

Lorsque Google déploie une mise à jour de base dans les résultats de recherche, cela a également un impact sur la façon dont le contenu apparaît dans Google Discover.

Si le trafic augmente ou diminue après une mise à jour principale, mais que vos classements de recherche sont stables, cela peut être dû à des changements dans Discover.

« Nous utilisons un certain nombre d’algorithmes de même qualité dans Discover que nous utilisons dans la recherche sur le Web. Lorsqu’une mise à jour générale se produit dans la recherche sur le Web, il est très courant que vous voyiez également des changements dans Discover. Ce n’est donc certainement pas totalement sans rapport.

55. Google n’indexe pas toutes les pages

Google n’indexe pas toutes les pages d’un site Web, même s’il les connaît.

Il est tout à fait normal, dit John Mueller que jusqu’à 20 % des pages ne soient pas indexées.

« L’autre chose à garder à l’esprit en ce qui concerne l’indexation, c’est qu’il est tout à fait normal que nous n’indexions pas tout à partir du site Web.

Donc, si vous regardez un site Web plus grand ou même un site Web de taille moyenne ou encore plus petit, vous verrez des fluctuations dans l’indexation.

Donc, si vous avez une centaine de pages et que 80 d’entre elles sont indexées, alors je ne considérerais pas cela comme un problème que vous devez résoudre.

56. Indexation lente ou rapide

Lorsqu’une nouvelle page est publiée, Google fait des hypothèses sur son classement.

Parfois, ces hypothèses finissent par être inexactes, c’est pourquoi une page peut initialement se classer haut, puis subir une chute brutale.

Encore une fois, nous n’essayons pas explicitement de promouvoir un nouveau contenu ou de rétrograder un nouveau contenu.

C’est juste que nous ne savons pas et nous devons faire des suppositions. Et puis parfois, ces hypothèses sont justes et rien ne change vraiment avec le temps.

Parfois, les choses s’installent un peu plus rapidement parfois plus lentement.

57. Un trafic faible ne signifie pas une qualité médiocre

Veillez à ne pas supposer qu’un faible trafic est une indication qu’une page est de mauvaise qualité.

Une page peut toujours être utile et de haute qualité , même si elle n’obtient pas autant de trafic que les autres pages d’un site.

Il est donc important de ne pas supprimer des pages de votre site simplement parce qu’elles ne génèrent pas autant de trafic que vous le souhaiteriez.

« Sur certains sites Web, les pages à faible trafic sont souvent presque corrélées à une faible qualité, mais cela ne doit pas nécessairement être le cas.

Sur d’autres sites Web, il se peut qu’une grande partie du trafic se dirige vers les pages de tête et les pages de queue sont tout aussi utiles, mais elles sont utiles pour un public beaucoup plus restreint.

Je ne supprimerais simplement pas ses pages parce qu’il n’y a pas de trafic.