Qu’est-ce que la norme d’exclusion des robots et qu’est-ce qu’un fichier Robots.txt?

Le fichier robots.txt est utilisé pour expliquer aux robots d’exploration de sites Web et à d’autres robots la structure d’un site Web. Il est ouvertement accessible et peut également être lu et compris rapidement et facilement par un humain.

Le fichier robots.txt peut indiquer aux robots d’exploration où trouver le (s) fichier (s) de sitemap XML, la rapidité avec laquelle le site peut être analysé et les pages d’un site WEB et les répertoires à analyser et ne pas analyser.

Avant qu’un bon robot explore une page Web, il vérifie d’abord l’existence d’un fichier robots.txt et le cas échéant, respecte les directives contenues dans ce fichier.

Le fichier robots.txt est l’une des premières choses qu’un bon spécialiste en SEO ou une agence SEO doit préparer. Il semble facile à utiliser et puissant. Cet ensemble de conditions entraîne une utilisation du fichier bien intentionnée, mais peut parfois présenter un risque élevé.

Afin d’empêcher un robot d’explorer une page Web ou un répertoire, la norme d’exclusion des robots repose sur les déclarations «Interdit» – dans lesquelles un robot n’est «pas autorisé» à accéder à la ou aux pages.

Le risque de sécurité du fichier Robots.txt

Le fichier robots.txt n’est pas une directive stricte, c’est simplement une suggestion. Les bons robots comme Googlebot respectent les directives du fichier.

De mauvais robots, cependant, peuvent complètement l’ignorer ou pire. En fait, certains robots néfastes et certains robots de test d’intrusion recherchent spécifiquement des fichiers robots.txt dans le seul but de consulter les sections interdites du site.

Si un acteur vicieux, qu’il soit humain ou robot, essaie de trouver des informations privées ou confidentielles sur un site Web, la liste d’interdictions du fichier robots.txt peut servir de carte d’accès. C’est le premier endroit, le plus évident à regarder.

De cette manière, si un administrateur de site pense utiliser le fichier robots.txt pour sécuriser son contenu et préserver la confidentialité des pages, il fait probablement exactement le contraire.

Il existe également de nombreux cas dans lesquels les fichiers exclus via la norme d’exclusion des robots ne sont pas de nature vraiment confidentielle, mais il n’est pas souhaitable qu’un concurrent les trouve. Par exemple, le fichier robots.txt peuvent contenir des détails sur les modèles d’URL de test A / B ou sur des sections du site Web nouvelles ou en cours de développement.

Dans ces cas, il ne s’agit peut-être pas d’un risque réel pour la sécurité, mais le fait de mentionner ces zones sensibles dans un document accessible comporte néanmoins des risques.

Quelles sont les meilleures pratiques pour réduire les risques liés aux fichier Robots.txt?

Il existe quelques meilleures pratiques pour réduire les risques posés par les fichiers robots.txt.

1. Comprendre à quoi sert un fichier Robots.txt et en quoi il sert.

La norme d’exclusion des robots ne vous aidera pas à supprimer une URL de l’index d’un moteur de recherche et n’empêchera pas un moteur de recherche d’ajouter une URL à son index.

Les moteurs de recherche ajoutent généralement des URL à leur index même s’ils ont reçu pour instruction de ne pas analyser l’URL. L’analyse et l’ URL d’indexation sont deux choses très différentes et distinctes et le fichier robots.txt ne servira pas à empêcher l’indexation des URL.

2. Soyez prudent lorsque vous utilisez Noindex et Robots.txt pour interdire un accès en même temps.

Il s’agit d’un cas extrêmement rare dans lequel une page aurait à la fois une balise noindex et une directive d’interdiction de robot. En fait, un tel cas ne devrait pas exister. Google affichait ce message dans les résultats de ces pages plutôt qu’une description: «Aucune description de ce résultat n’est disponible en raison du fichier robots.txt de ce site«.

Dernièrement, cela semble avoir été remplacé par «Aucune information disponible pour cette page».

3. Utilisez Noindex, not Disallow, pour les pages que vous voulez rendre privées et accessibles au public.

En faisant cela, vous pouvez vous assurer que si un bon robot trouve une URL qui ne devrait pas être indexée, elle ne le sera pas.

Pour le contenu avec ce niveau de sécurité requis, un robot d’exploration peut accéder à l’URL, mais pas en indexer le contenu.

Pour les pages qui doivent être privées et non accessibles au public, la protection par mot de passe ou la mise en liste blanche IP constituent les meilleures solutions.

4. Configurer un piège pour IP à black listé.

Si vous souhaitez améliorer votre sécurité, envisagez de configurer un pot de miel à l’aide de votre fichier robots.txt. Incluez une directive interdire dans le fichier robots.txt qui semble séduisante pour les personnes malveillantes, telle que «Disallow: /admin/logins.html».

Ensuite, configurez la journalisation IP sur la ressource non autorisée. Toutes les adresses IP qui tentent de charger le fichier «logins.html» doivent ensuite être placées sur une black liste d’IP pour bloquer l’accès à votre site ou certains répertoires.

En conclusion

Le fichier robots.txt est un outil de référencement essentiel pour informer les bons robots sur la manière dont vous voulez qu’ils traitent vos fichiers et vos contenus.

Si vous avez des pages Web qui devraient être accessibles au public, mais ne pas apparaître dans les résultats de recherche, la meilleure approche consiste à utiliser une balise noindex robots sur les pages elles-mêmes (ou une réponse entête X-Robots-Tag).

Ajouter simplement une liste d’URL destinées à être privées à un fichier robots.txt est l’un des pires moyens de masquer les URL. Dans la plupart des cas, cela aboutit à l’opposé du résultat souhaité.

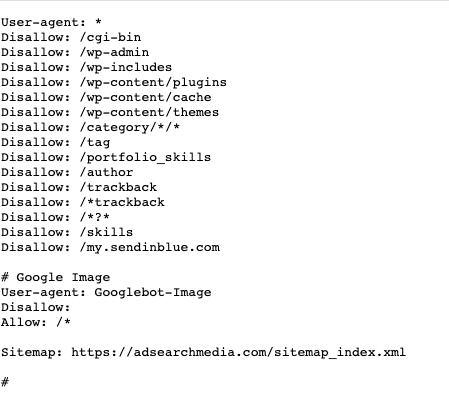

Exemple d’un fichier robots.txt ci-dessous: